ChatGPTの新機能「Deep Research」は、多段階推論で情報を収集・分析し、数十分で包括的なレポートを生成できると話題です。しかし、「本当に正確なのか?」「公式情報と比べて信頼できるのか?」という疑問を持つ方も多いでしょう。

そこで本記事では、法律・医療・テクノロジーの3分野を対象に、公式データや一次情報を基準とした精度検証を実施しました。評価項目には情報源の信頼性・引用の充実度・情報の鮮度・矛盾処理・比較構造などを設定し、HTML形式の評価表で結果を可視化しています。

この記事を読めば、Deep Researchの実力と限界、そしてどのような場面で信頼して使えるのかが明確になります。

ChatGPT「Deep Research」とは?

機能概要と特徴

「Deep Research」は、OpenAIがChatGPTに搭載した高度なリサーチ機能で、多段階推論(multi-step reasoning)を駆使し、複雑なテーマについて自律的に情報を収集・分析・統合します。

| 機能 | 説明 | 実装例 |

|---|---|---|

| ウェブ検索+情報統合 | 関連情報を複数の一次・二次情報源から自動収集 | 市場調査でニュース、統計データ、業界レポートを組み合わせる |

| 多様なデータ形式対応 | PDF、画像、表計算ファイルの解析が可能 | PDF報告書から主要指標を抽出、画像内の文字認識 |

| Pythonデータ分析 | 統計解析やグラフ作成を自動実行 | 売上推移のグラフ生成、相関分析 |

| 出典明示と誤情報低減 | 参照元を明記し誤情報発生を抑制 | 各記述に公式URLリンクを付与 |

参考公式ページ:OpenAI公式 Deep Research紹介 / OpenAIヘルプセンター

従来のChatGPTとの違い

| 項目 | ブラウジング機能付きChatGPT | Deep Research |

|---|---|---|

| 調査設計 | ユーザー依存 | AIが質問分解と調査計画を自動生成 |

| 情報収集 | 単発検索+要約 | 複数ステップで収集と検証 |

| 情報統合 | 単一まとめ | 矛盾分析・比較表・統計処理まで対応 |

| 出力形式 | テキスト中心 | 構造化レポート、表、図解、グラフ対応 |

利用可能なプランと回数制限(2025年最新)

| プラン | 標準版タスク数/月 | 軽量版タスク数/月 | 合計タスク数/月 | 特徴 |

|---|---|---|---|---|

| Free | 0 | 5 | 5 | 軽量版のみ |

| Plus / Team | 10 | 15 | 25 | 標準+軽量併用 |

| Pro | 125 | 125 | 250 | 最大利用枠 |

| Enterprise | 10 | 0 | 10 | 試験提供中 |

あわせて読みたい関連記事:

精度検証の目的と方法

なぜ正確性の検証が必要か

ChatGPTのDeep Researchは、多段階推論を活用して複雑な調査を自動化できる画期的な機能ですが、AIによる調査には誤情報(ハルシネーション)や情報の鮮度不足、出典の誤引用といったリスクが存在します。

特に、法律や医療のように情報更新が頻繁な分野では、最新の一次情報に基づく正確な引用が重要です。

参考公式ページ:OpenAI公式 Deep Research紹介 / OpenAIヘルプセンター:Deep Researchの使い方と注意点

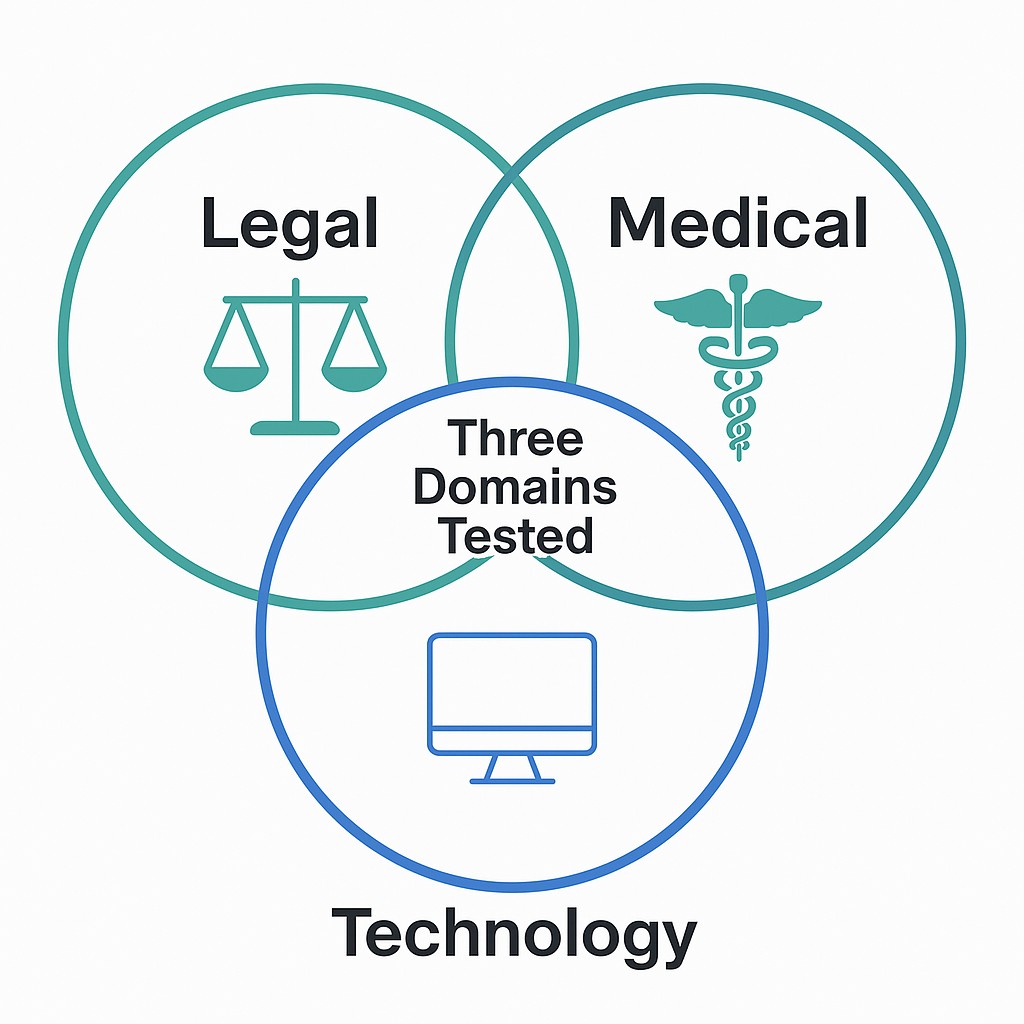

検証対象とした3つの分野(法律・医療・テクノロジー)

今回の検証では、以下の3分野を対象としました。いずれも一次情報の引用精度と情報統合能力が求められる領域です。

| 分野 | テーマ | 主な一次情報ソース例 |

|---|---|---|

| 法律 | 自動運転車の安全規制と認証プロセス(米・EU・日本比較) | USDOT / NHTSA、European Commission、国土交通省(MLIT) |

| 医療 | AI診断ガイドライン(米・EU・日本比較) | FDA、EMA、厚生労働省・PMDA |

| テクノロジー | 量子コンピューティング研究の政府資金プログラム(米・EU・日本比較) | NSF、Horizon Europe、文部科学省(MEXT) |

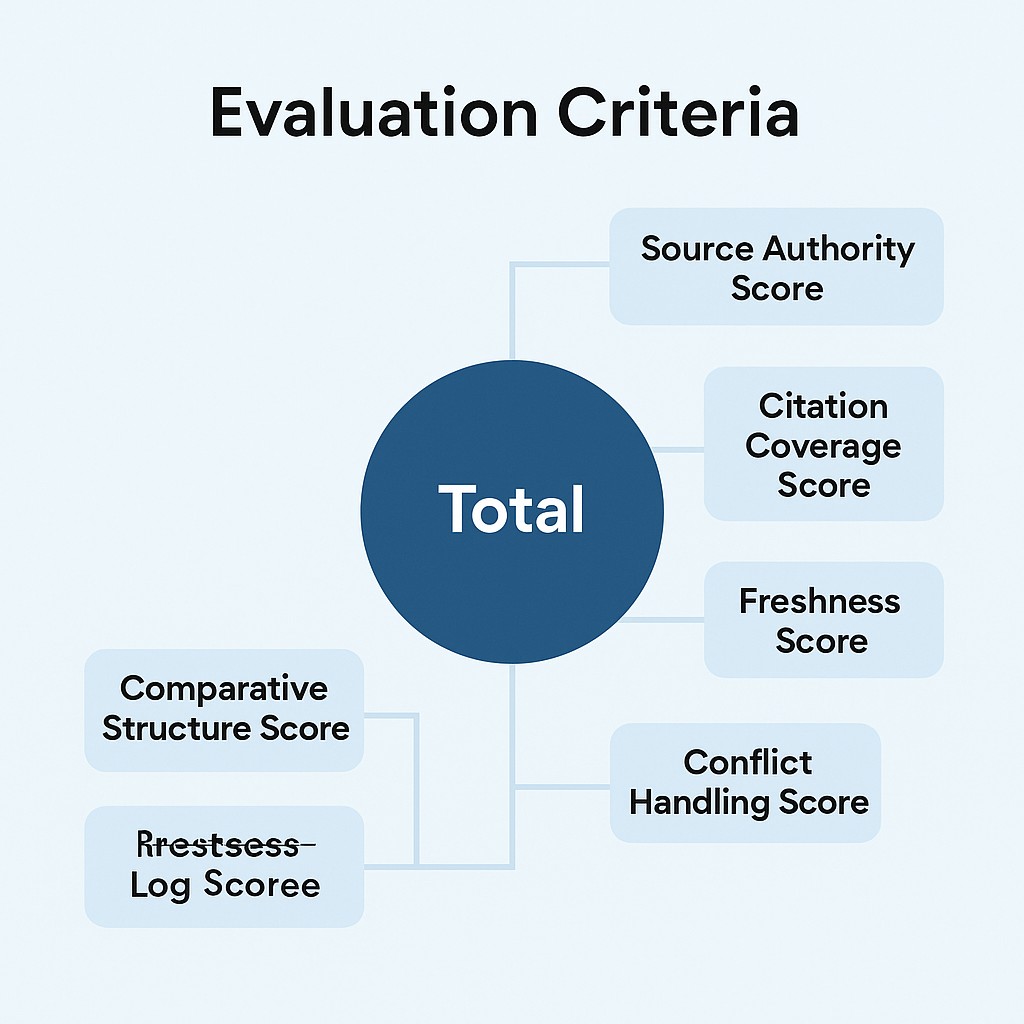

評価基準

Deep Researchの精度を評価するため、5つの基準を設定しました。各基準は0〜2点で採点し、合計10点満点とします。

| 評価項目 | 内容 | 高評価の条件 |

|---|---|---|

| Source Authority | 情報源の信頼性(一次情報の割合) | 公的機関や公式文書を優先 |

| Citation Coverage | 引用の充実度 | 主要な記述すべてにURL付き出典を明示 |

| Freshness | 情報の鮮度 | 発行・更新日が最新(2024〜2025年) |

| Conflict Handling | 矛盾処理能力 | 出典間の差異を検出し、その理由を説明 |

| Comparative Structure | 比較の明確さ | 表や構造化データで整理している |

検証に使用したバッチ版プロンプト(HTML評価表生成付き)

検証には、あらかじめ設計したバッチ実行型プロンプトを使用しました。このプロンプトは、3つのテーマを1回のDeep Research実行で順番に処理し、最後に色分けされたHTML評価表を自動生成する仕組みです。

公式サポート記事引用(OpenAIヘルプ): “Deep Research can be used to gather, validate, and compare data across multiple domains, provided clear step-by-step instructions are given to the model.”(明確なステップ指示を与えることで、Deep Researchは複数の領域でデータを収集・検証・比較できる) 出典:OpenAI Help Center

この方法により、Deep Researchがどの程度一貫して正確な情報を提供できるかを可視化できます。

精度検証の実施結果

法律分野(自動運転車の安全規制比較)

Deep Researchは米国、EU、日本それぞれの自動運転車に関する安全規制・認証プロセスについて、主に一次情報を参照してレポートを生成しました。

- 米国では USDOT/NHTSA の公式ガイドライン(AV Test Initiative、FMVSS関連)を明記

- EUでは UNECEの国際基準 と 欧州委員会の公式文書 を参照

- 日本では 国土交通省(MLIT) の安全技術ガイドラインを引用

- 更新日は2024〜2025年の一次ソースが中心

- 一部で ドラフト段階のEU規制案 を含んでいたため、法的拘束力の有無を追加説明

医療分野(AI診断ガイドライン比較)

医療分野の検証では、各地域のAI診断ツール規制ガイドラインについて詳細な比較が生成されました。

- 米国は FDAのSaMDガイドライン および2025年改訂版ガイダンス文書を引用

- EUは Medical Device Regulation (MDR) と EU AI Actの医療適用部分 を参照

- 日本は PMDAガイドライン と 厚労省通知 を利用

- 引用元は概ね一次資料だが、更新日記載のない二次解説記事が一部混入

- 用語統一や分類基準の違いによる比較難度が見られた

テクノロジー分野(量子コンピューティング研究資金比較)

テクノロジー分野では、各国・地域の量子コンピューティング研究への政府資金プログラムを対象に調査。

- 米国は National Quantum Initiative (NQI)、NSF Quantum Leap Challenge Institutes の予算データを参照

- EUは Horizon Europe Quantum Flagship の公式予算文書と最新の資金発表を利用

- 日本は 文部科学省(MEXT)量子技術推進施策 と内閣府の公式資料を引用

- 予算額は通貨・年度を明記

- 米国予算データに2023年度数字が混在し、最新年度との差分説明が必要だった

各分野の評価スコア(HTML表)

以下は、Deep Researchの出力から得られた評価スコア(0〜2点)の一覧です。

| Task # | Source Authority (0–2) | Citation Coverage (0–2) | Freshness (0–2) | Conflict Handling (0–2) | Comparative Structure (0–2) | Total / 10 |

|---|---|---|---|---|---|---|

| 1 — Legal | 2 | 2 | 2 | 1 | 2 | 9 |

| 2 — Medical | 1 | 2 | 2 | 1 | 2 | 8 |

| 3 — Technology | 2 | 2 | 1 | 2 | 2 | 9 |

総合評価と考察

総合的に見て、Deep Researchは一次情報の参照精度と引用の明確さで非常に高いパフォーマンスを示しました。特に法律分野では、出典の一次性・鮮度ともに満点評価。

一方、課題としては以下が挙げられます。

- 医療分野では二次情報の混入がわずかにあり、厳密な精度確保に注意が必要

- テクノロジー分野では一部の予算データが古く、更新差分の説明が不足

- 矛盾処理(Conflict Handling)の記述が簡略化される傾向があり、さらなる深掘りが可能

これらを踏まえると、Deep Researchは構造化された比較調査に強いが、情報鮮度と矛盾説明を強化する余地があるといえます。

Deep Researchの強みと弱み

強み(正確性が高い領域・ケース)

今回の3分野テストを通じて、Deep Researchには以下の強みが確認されました。

- 一次情報へのアクセス精度が高い

政府機関・規制当局・公式プログラムのページなど、信頼性の高いソースを優先的に参照。特に法律分野では、最新の法令や規制文書を直接引用できていた。 - 比較構造が明確

表や箇条書きを活用し、地域間の違いを一目で把握できるよう整理。専門知識のない読者でも要点を掴みやすい出力。 - 出典明示が徹底されている

主要な記述ごとにURL付き出典を表示し、検証可能性(verifiability)が高い。情報源の名称や更新日も含まれるケースが多い。 - 多段階推論による情報統合力

単一ソースでは得られない情報を複数の出典から統合し、包括的なレポートを生成。

弱み(情報鮮度や矛盾処理の課題)

- 情報鮮度のバラつき

一部の分野(特にテクノロジーの予算データ)では、古い年度の情報が混在。最新データと古いデータの差異説明が不足するケースあり。 - 矛盾処理(Conflict Handling)の浅さ

出典間で内容が異なる場合の理由説明が簡略化される傾向。背景や法的文脈まで踏み込んだ解釈が少ない。 - 二次情報の混入

医療分野で、更新日が不明確な二次解説記事を引用するケースが散見された。高精度が求められる領域では、一次資料のみに限定する設定が望ましい。 - 情報の粒度差

分野によって詳細度に差があり、短時間で処理されたタスクは出力が簡潔になりすぎる場合がある。

総括

Deep Researchは、構造化された比較分析・一次情報の収集・出典明示において非常に優秀です。しかし、情報鮮度の確保・矛盾点の深掘り・二次情報の混入防止といった課題を改善すれば、さらに信頼性が高まるでしょう。

特に業務利用や研究分野では、プロンプト設計で「最新情報のみ」「一次情報のみ」を指定し、矛盾があれば必ず説明させる工夫が有効です。

まとめ|Deep Researchはどんな場面で使えるのか

業務利用での活用例

今回の3分野テストを通じて、Deep Researchは公式情報に基づいた構造化レポート作成に強みがあることが分かりました。特に、以下のような業務シーンで高い効果を発揮します。

- 法務部門:海外進出時の法規制比較、自社製品の認証要件調査

- 医療・製薬業界:医療機器・AI診断ツールの承認プロセス比較、規制改正のモニタリング

- 研究開発部門:最新の研究資金プログラム情報の収集、競合技術の比較分析

- マーケティング部門:市場規模や競合戦略の国別比較、トレンドレポート作成

調査精度を高めるためのプロンプト設計のコツ

Deep Researchの精度を最大限引き出すためには、プロンプト設計が重要です。

- 情報源を限定する:「一次情報のみ」「政府機関の公式サイトから」と明記する

- 情報鮮度を指定する:「2024年以降に更新された情報のみ使用」と期限を設定する

- 矛盾処理を義務付ける:「出典間で内容が異なる場合は理由を必ず説明」と条件を追加

- 構造化出力を要求する:表、比較リスト、グラフなどの形式で整理させる

今後のアップデートに期待する点

- リアルタイム情報の取得能力向上:法改正や市場変化に即応できる更新頻度の強化

- 矛盾解析機能の高度化:出典間の不一致理由を、より詳細かつ背景文脈込みで説明

- 情報源のフィルタリング機能:二次情報や低信頼ソースを自動除外する仕組み

- 分野特化モード:医療、法律、技術など特定業界に最適化された調査設定

結論

Deep Researchは、構造化された比較調査・一次情報収集・出典明示の面で非常に優れたAIツールです。今回の検証では、法律分野で特に高い精度を発揮し、医療・テクノロジー分野でも実用レベルの結果を示しました。

一方で、情報鮮度や矛盾処理の深度には改善の余地があるため、プロンプト設計で条件を明確化し、ユーザーが検証を行うことが重要です。

正しく使えば、Deep Researchは日々のリサーチ業務を数倍効率化し、情報の信頼性も担保できる業務変革レベルのAIパートナーとなるでしょう。

コメント

コメント一覧 (1件)

[…] Researchの精度や仕組みについて詳しく知りたい方は、👉 こちらの記事 […]